KI-Assistenten werden für die Verwaltung der Kommunikation in Unternehmen immer wichtiger, insbesondere in den Bereichen Support und Betrieb. Von der Empfehlung von E-Mail-Antworten bis hin zur Bearbeitung ganzer Konversationen ermöglichen sie es Teams, zu skalieren, ohne die Arbeitsbelastung zu erhöhen, und die Kunden erhalten im Gegenzug einen schnelleren und genaueren Service.

Aber wie genau arbeiten KI-Assistenten hinter den Kulissen? Was macht ihre Fähigkeit, im Laufe der Zeit zu verstehen, zu reagieren und sich zu verbessern?

Lassen Sie uns das aufschlüsseln.

Was sind KI-Assistenten?

KI-Assistenten sind Softwaresysteme, die natürliche Sprache verarbeiten, relevante Informationen abrufen und Maßnahmen ergreifen, indem sie entweder Inhalte generieren, Aufgaben automatisieren oder direkt auf Benutzer reagieren.

Im Gegensatz zu Chatbots, die starren Wenn-dies-dann-das-Regeln folgen, basieren moderne KI-Assistenten auf Sprachmodellen, maschinellem Lernen und Abrufsystemen. Sie stimmen nicht nur auf Keywords ab, sie interpretieren den Kontext, priorisieren die Dringlichkeit und verbessern sich mit der Nutzung.

📊 Laut eine von Servion Global Solutions durchgeführte Studie, 95% der Kundeninteraktionen werden bis 2025 auf KI basieren, ein klares Zeichen dafür, dass KI-Assistenten kein Luxus sind, sondern eine Kernebene der Support-Infrastruktur.

👉 Sie können eine vollständige Aufschlüsselung von erkunden was ist ein KI-Assistent, und wie es sich von den einfachen Chatbots in diesem Gmelius-Blog unterscheidet.

Schlüsseltechnologien, die KI-Assistenten unterstützen

Der Aufbau eines KI-Assistenten erfordert mehr als nur ein LLM (Large Language Model). Hier sind die wichtigsten Komponenten, die moderne Assistenten intelligent, schnell und zuverlässig machen:

- Verarbeitung natürlicher Sprache (NLP):

Zerlegt Sätze in ihre Bestandteile (Zeichen, Wortarten), um zu verstehen, was der Benutzer meint, nicht nur, was er sagt. - Große Sprachmodelle (LLMs):

Dies sind die Kern-Engines (wie GPT-4 oder Claude von OpenAI), die Antworten generieren. Sie wurden anhand von Milliarden von Beispielen geschult, um Grammatik, Absicht und Stil zu verstehen. - Augmentierte Generierung (RAG):

Anstatt sich ausschließlich auf Trainingsdaten zu verlassen, ruft RAG relevante Informationen aus einer verbundenen Quelle (z. B. Ihren Hilfedokumenten) ab und leitet sie an das LLM weiter. Dadurch werden die Antworten genauer und kontextbezogener. - Absichtsklassifizierung und Entitätsextraktion:

Legt fest, was der Benutzer tun möchte (z. B. „Abonnement kündigen“) und ruft alle wichtigen Informationen (z. B. die Konto-ID) ab, um die Aufgabe auszuführen. - Wissensgrafiken:

Strukturierte Datenbanken, die Beziehungen zwischen Dingen abbilden, z. B. welche Kunden für welche Stufe in Frage kommen oder welche Richtlinien für welche Regionen gelten. Diese helfen Assistenten, komplexere Szenarien zu durchdenken. - Stimmungs- und Emotionsanalyse:

Zeigt an, ob der Benutzer frustriert, verwirrt oder glücklich ist, was für die Priorisierung oder Anpassung des Tons unerlässlich ist. - Verstärktes Lernen durch menschliches Feedback (RLHF):

Die KI lernt anhand von positiven, negativen Bewertungen oder Folgekorrekturen, welche Antworten hilfreich sind. Dadurch wird der Kreislauf geschlossen und der Assistent wird kontinuierlich verbessert. - Text-to-Speech und Speech-to-Text:

Ermöglicht Sprachinteraktionen in Apps, Telefonsupport oder intelligenten Geräten. - Sichere Vektor-Einbettungsspeicher:

Speichern Sie Wissensdatenbankinhalte als Vektoren (semantische Bedeutung, nicht nur Wörter) und ermöglichen Sie so eine schnelle, private semantische Suche in Ihrer eigenen Cloud-Umgebung. - Tool- und API-Orchestrierung:

Der Assistent muss möglicherweise APIs aufrufen, Workflows auslösen oder Daten aus Drittanbieter-Tools abrufen. Orchestrierungs-Frameworks verwalten diese Interaktion sicher.

Schritt für Schritt: Wie ein KI-Assistent auf eine Anfrage reagiert

KI-Assistenten mögen magisch erscheinen, aber unter der Haube folgen sie einer klaren technischen Pipeline. So funktioniert der Prozess in der Regel:

1. Erfassung eingeben

Der Assistent beginnt mit Benutzereingaben, die aus verschiedenen Kanälen stammen können: einer eingegebenen E-Mail, einer Live-Chat-Nachricht, einem Kontaktformular oder einer Stimme über eine Callcenter-Oberfläche. Jede dieser Eingaben wird über APIs oder integrierte Widgets erfasst und an die Verarbeitungspipeline des Assistenten weitergeleitet. Eingabeformate werden in einer strukturierten Anfrage für nachgelagerte Aufgaben standardisiert, die häufig Sitzungsmetadaten (Zeitstempel, Kanal, Benutzer-ID) zur Kontextsensibilität enthält.

2. Spracherkennung (wenn die Eingabe Sprache beinhaltet)

Wenn der Benutzer spricht, anstatt zu tippen, aktiviert das System eine Automatische Spracherkennung (ASR) Engine zur Umwandlung von Audiosignalen in Text. Dieser Prozess umfasst Wellenformanalyse, Phonemerkennung und Sprachmodellierung. Moderne ASR-Systeme verwenden häufig Deep-Learning-Modelle (wie Wav2Vec 2.0 oder Whisper), die auf mehrsprachigen und domänenspezifischen Datensätzen trainiert wurden, um die Transkriptionsgenauigkeit in lauten Umgebungen oder mit nicht-nativen Akzenten zu verbessern.

3. Vorverarbeitung

Rohtext wird normalisiert, um Variationen in Rechtschreibung, Zeitform und Formatierung zu verarbeiten. Dazu gehören Tokenisierung, Lemmatisierung (Reduzierung von „running“ auf „run“) und die Erweiterung von Abkürzungen oder Umgangssprache („tmrw“ → „tomorrow“). Persönlich identifizierbare Informationen (PII) z. B. E-Mail-Adressen oder Kontonummern werden geschwärzt oder maskiert, sowohl aus Datenschutzgründen als auch um Verzerrungen nachgelagerter Modellvorhersagen zu vermeiden. Das Ergebnis ist eine saubere, semantisch umfangreiche Eingabe, die für das Intent-Parsen bereit ist.

4. Erkennung von Absichten

Ein trainierter Absichtsklassifikator (der in der Regel auf Transformatormodellen wie BERT oder RobertA basiert) ordnet Benutzereingaben einer vordefinierten Intent-Klasse zu. Zum Beispiel: „Kann ich meine Rechnung vom letzten Monat überprüfen?“ kann mit der Absicht billing_view_invoice markiert sein. Vertrauensschwellen werden durchgesetzt, um Unklarheiten und Ausweichantworten zu vermeiden (z. B. „Können Sie Ihre Anfrage präzisieren?“) werden ausgelöst, wenn die Unsicherheit ein festgelegtes Limit überschreitet. Mehrsprachigkeit und Multi-Intent-Funktionen können je nach Umfang des Assistenten ebenfalls unterstützt werden.

5. Extraktion von Entitäten

Verwenden Erkennung benannter Entitäten (NER), der Assistent identifiziert strukturierte Datenpunkte wie Bestellnummern, Produkt-SKUs, Datumsbereiche oder Standorte. Diese Entitäten werden mit Anmerkungen versehen und in einem Kontextobjekt gespeichert, das während der gesamten Konversation erhalten bleibt. Extraktionsmodelle können regelbasiert (Regex) oder ML-basiert sein, abhängig von der Komplexität der Entitätstypen und der Domänenspezifität. Diese Werte sind entscheidend für API-Aufrufe, das automatische Ausfüllen von Formularen oder die kontextbezogene Suche.

6. Abrufen des Kontextes

Mit Absicht und Entitäten fragt der Assistent relevante Datenquellen ab, z. B. eine Vektordatenbank mit Artikeln aus der Wissensdatenbank (mithilfe von Einbettungen über OpenAI oder Cohere), Aufzeichnungen zum Kundenbeziehungsmanagement (CRM) oder Aufzeichnungen vergangener Konversationen. Die semantische Ähnlichkeitssuche stellt sicher, dass nicht nur Keyword-Treffer, sondern auch konzeptionell verwandte Einträge abgerufen werden. Der Assistent erstellt einen Kontext-Stack, auf den Sie bei der Entscheidungsfindung und bei der Generierung von Antworten zurückgreifen können.

7. Entscheidungsfindung

Basierend auf der Absicht, den Entitäten und dem abgerufenen Kontext wählt der Assistent die nächste Aktion aus. Dabei kann es sich um eine fest programmierte Regel handeln (z. B. „if intent = reset_password → workflow auslösen“) oder um eine dynamische Richtlinien-Engine, die auf Reinforcement Learning oder Entscheidungsbäumen basiert. Fortgeschrittene Systeme können KI-Planungsalgorithmen zur Sequenzierung mehrerer Aktionen enthalten. Wenn eine Eskalation erforderlich ist (z. B. wenn die Absicht sensibel oder komplex ist), leitet der Assistent die Anfrage mit vorausgefülltem Kontext an einen Mitarbeiter weiter.

8. Generierung von Antworten

Der Assistent erstellt nun eine Antwort mit Augmentierte Generierung (RAG). Dabei werden abgerufene Daten (z. B. ein Hilfeartikel oder ein Benutzerprofil) mit einem Sprachmodell wie GPT kombiniert, um personalisierte Antworten in natürlicher Sprache zu generieren. Für transaktionale Zwecke kann es APIs aufrufen, um Live-Daten (z. B. den Bestellstatus) abzurufen oder Backend-Prozesse einzuleiten. Die Antworten sind nach Tonfall, Länge und Klarheit formatiert, wobei häufig nur wenige Eingabeaufforderungen verwendet werden, um der Stimme des Unternehmens gerecht zu werden.

9. Leitplanken

Vor dem Versand führt das System mehrere Sicherheitsprüfungen durch. Dazu gehören Richtlinienfilter (z. B. das Senden von Anmeldedaten verhindern), Tonanalysen (stellen Sie sicher, dass der Assistent nicht unhöflich oder abweisend klingt) und menschliche Kontrollpunkte für bestimmte Kategorien (z. B. Kunden aus den Bereichen Recht, Compliance, VIP-Kunden). Toxizitätsklassifizierer, PII-Detektoren und Ratenbegrenzer tragen dazu bei, ein verantwortungsvolles Verhalten der KI sicherzustellen. Die Protokollierung erfolgt parallel zur Einhaltung von Vorschriften und zur Überprüfung.

10. Lieferung + Protokollierung

Nach der Genehmigung übermittelt der Assistent die Antwort über denselben Kanal, über den sie gekommen ist — E-Mail, Chat oder Spracheingabe. Gleichzeitig protokolliert er die Sitzungsmetadaten, die Nutzerzufriedenheitswerte (per Daumen hoch oder CSAT-Eingabeaufforderungen) und wichtige Kennzahlen wie Zeit bis zur ersten Antwort (TTFR) oder Lösungszeit. Diese Daten fließen in die Trainingspipeline ein, wo eine überwachte Feinabstimmung oder RLHF (Reinforcement Learning from Human Feedback) die zukünftige Leistung verbessert.

Mit der Zeit verbessert sich diese Schleife. Neue Artikel werden indexiert, neue Muster werden erlernt und Feedback aktualisiert das Modell. Das Ergebnis? Ein intelligenterer Assistent, der mit Ihrem Produkt, Ihren Kunden und Ihren Arbeitsabläufen Schritt hält.

Neugierig auf die breiteren Auswirkungen? Erfahren Sie mehr über wie KI-Assistenten Unternehmen helfen verbessern Sie die Effizienz, senken Sie die Kosten und skalieren Sie intelligenter.

Beispiele aus der Praxis: KI-Assistenten in Gmail

Mit Plattformen wie Gmelius, KI-Assistenten sind direkt in Gmail eingebettet. Sie benötigen keine neue App, nur intelligentere E-Mails.

Die KI-Assistenten von Gmelius gehen über die Automatisierung auf oberflächlicher Ebene hinaus. Sie können eine sichere Verbindung zu Ihrer internen Dokumentation, Ihrem Help Center oder Ihrer Wissensdatenbank herstellen, um Antworten zu liefern, die auf den tatsächlichen Arbeitsabläufen und der Sprache Ihres Unternehmens basieren.

Sobald die Verbindung hergestellt ist, erstellt der Assistent einen sicheren, privaten Vektorindex Ihrer Inhalte — vollständig verschlüsselt und niemals geteilt oder zum Trainieren externer Modelle verwendet. Der Assistent basiert auf der Gemini-KI von Google und ist tief in Gmail eingebettet. Er aktualisiert sein Wissen jede Woche kontinuierlich und stellt sicher, dass es Ihre neuesten Prozesse, Richtlinien und Teamkenntnisse präzise und vertraulich widerspiegelt.

Hier sind zwei Beispiele aus der Praxis:

Gmelius E-Mail-Antwortassistent

Dieser Assistent entwirft intelligente Antworten auf eingehende E-Mails auf der Grundlage des Konversationsthreads, der gespeicherten Vorlagen und der Wissensdatenbank des Unternehmens. Er versteht den Ton, die Absicht und die Dringlichkeit, sodass menschliche Agenten sie einfach überprüfen und versenden können.

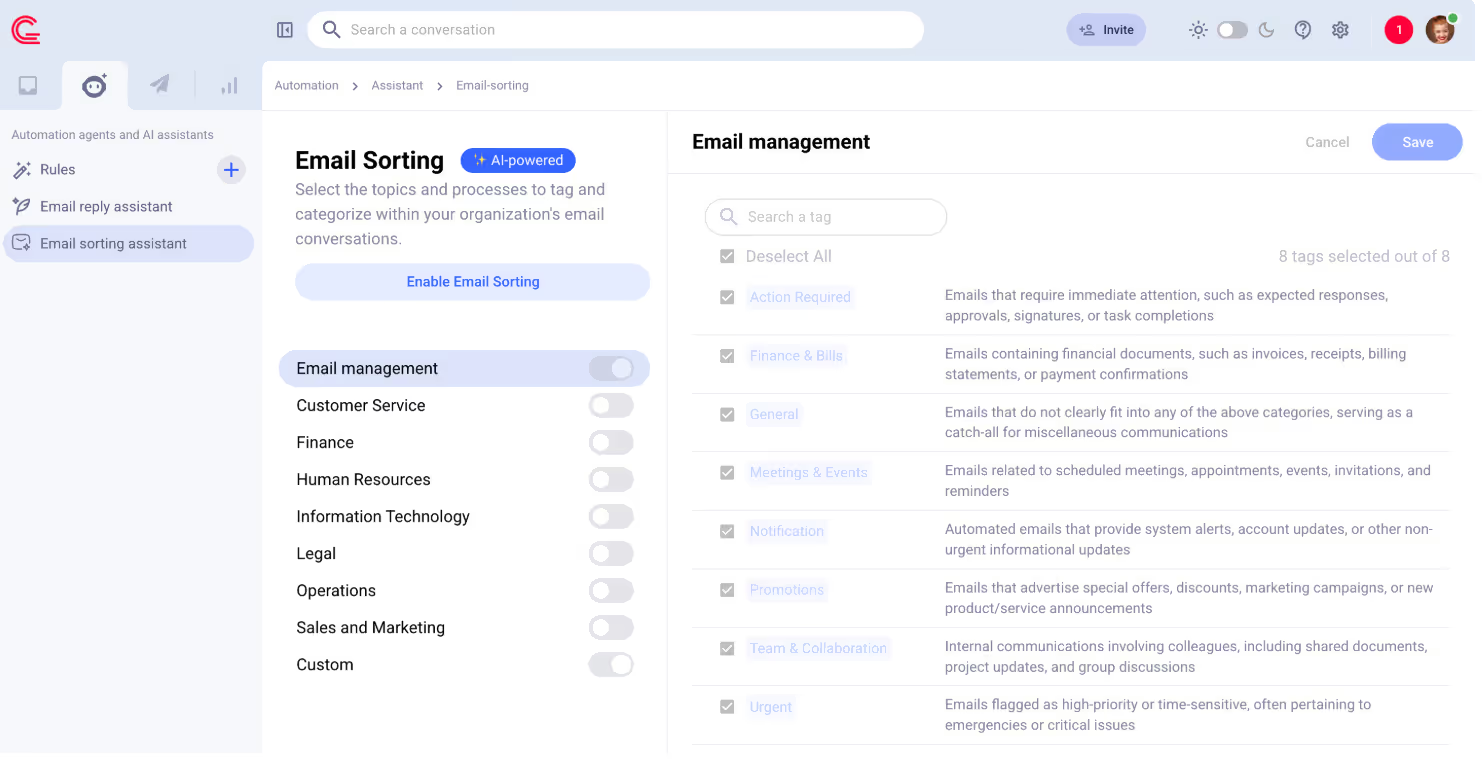

Gmelius E-Mail-Sortierassistent

Klassifiziert E-Mails (Abrechnung, Support, Feedback usw.) automatisch und leitet sie an die richtige Person oder den richtigen Tag weiter. Teams machen die manuelle Sortierung überflüssig und reduzieren die Antwortzeiten auf ganzer Linie.

So lassen Sie KI-Assistenten für Sie arbeiten

Wenn Sie darüber nachdenken, Ihrem Support- oder Betriebsworkflow einen KI-Assistenten hinzuzufügen, sollten Sie die folgenden Best Practices berücksichtigen:

1. Beginne mit der Wiederholung

Identifizieren Sie die 3—5 Aufgaben, die Sie am häufigsten wiederholen: „Wo ist meine Bestellung?“ , „Wie setze ich mein Passwort zurück?“ , „Kann ich eine Kopie meiner Rechnung erhalten?“ Dies sind einfache Vorteile für die Automatisierung.

2. Nutze dein eigenes Wissen

Laden Sie interne Dokumente, Produkthandbücher und FAQ-Inhalte hoch. Dadurch wird sichergestellt, dass Ihr Assistent Antworten in Ihrer Sprache gibt und dabei genaue Informationen verwendet.

3. Halten Sie die Menschen auf dem Laufenden

Lassen Sie bei komplexen oder sensiblen Antworten immer die Zustimmung des Agenten einholen, insbesondere in der ersten Phase. KI sollte Ihr Team unterstützen, nicht ersetzen.

4. Leistung verfolgen

Schau dir Metriken an wie:

- Erste Reaktionszeit (FRT)

- Zeit bis zur Lösung (TTR)

- Ablenkungsrate (wie viele Anfragen wurden ohne Beteiligung des Agenten bearbeitet)

5. Oft aktualisieren

Legen Sie einen Zeitplan für wiederkehrende Updates fest, sodass Ihr Assistent alle neuen Help-Center-Inhalte, Produktänderungen oder Richtlinienänderungen berücksichtigt.

6. Verbessern Sie die Aufforderung im Laufe der Zeit

Da der Assistent mehr Anfragen bearbeitet, schauen Sie sich an, welche er nicht gut beantwortet. Verfeinern Sie Ihre Schulungsmaterialien und Aufforderungen, um diese Lücken zu schließen.

Fazit

KI-Assistenten sind bereits Teil des täglichen Workflows in Tausenden von Support-Teams, SaaS-Unternehmen und E-Commerce-Betrieben. Wenn sie mit Ihrer tatsächlichen Wissensdatenbank verbunden sind und mit den richtigen Leitplanken gesteuert werden, reduzieren sie die Arbeitsbelastung, verbessern das Kundenerlebnis und helfen Teams, intelligenter zu werden.

Was früher stundenlange menschliche Arbeit erforderte (Nachrichten weiterleiten, Daten abrufen, konsistent reagieren), wird jetzt in Sekunden von intelligenten Assistenten erledigt, die lernen, sich anpassen und mit Ihrem Unternehmen skalieren.

Egal, ob Sie ein wachsendes Startup oder ein etabliertes Team sind, das unter E-Mails begraben ist, die Botschaft ist klar: Wenn Sie immer noch alles manuell erledigen, sind Sie bereits im Rückstand.

Mit Tools wie Gmelius KI-Assistenten, Sie müssen Ihren Stack nicht überarbeiten oder Ihre eigene Lösung entwickeln. Sie schließen es einfach an Gmail an — und lassen es funktionieren.

👉 Testen Sie Gmelius kostenlos

.avif)

.avif)

.avif)

.avif)

.avif)

.avif)